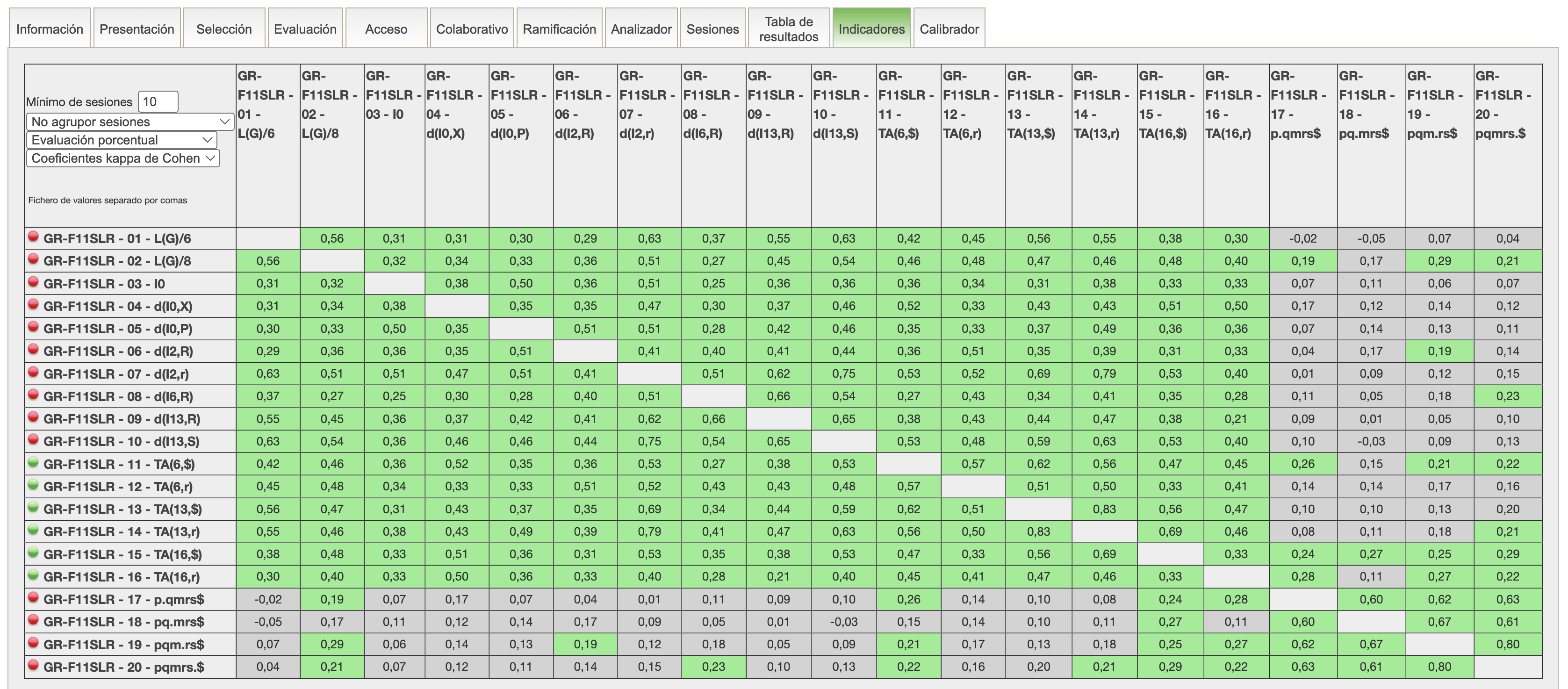

Coeficientes Kappa de Cohen

Esta tabla se configura mediante los controles que aparecen en su esquina superior izquierda, tal como se describe en la página Indicadores.

La tabla muestra el Coeficiente kappa de Cohen entre las respuestas dadas a cada par de ítems. Es una medida de la concordancia entre las respuestas a uno u otro ítem. Su interpretación viene dada si asumimos que cada ítem de un test es como una opinion de un juez sobre el conocimiento de una materia. El coeficiente mide si la opinion de dos jueces es o no conincidente.

El valor de este coeficiente varía entre -1 y +1. Un coeficiente cercano a 1 quiere decir que siempre que las respuestas a estas dos preguntas coinciden en su mayoría, es decir cuando se selecciona en uno de los ítems tambien se selecciona la opción correcta en el otro y viceversa. Por el contrario un coeficiente cercano a -1 indica que hay una discrepancia absoluta entre ambas respuestas.

Los valores positivos se representan en verde, y los negativos en rojo. Si no se puede excluir con un 95% de probabilidad que el coeficiente sea nulo, el valor aparecerá en gris. si dos preguntas no han aparecido conjuntamente, la casilla correspondiente de la tabla estará en blanco.

Este indicador solo trata de alertar sobre determinados comportamientos de los ítems. Por ejemplo un valor de kappa cercano a 1 entre dos ítems nos dice que ambos ítems son muy parecidos y que por tanto no son realmente informativos. Supongamos por ejemplo un test en el que todos los ítems tienen entre si un valor de kappa cercano a 1. Probablemente la evaluación del test sería la misma si solo se usara un ítem, ya que se podría predecir sin error la respuesta al resto de las preguntas.

Valores negativos in embargo no son deseables, ya que no tiene sentido si dos ítems miden un mismo rasgo latente que haya una disparidad tan acusada entre las respuestas a una u otra pregunta.